di Gaetano Di Palo

Il tema education policy da sempre rappresenta, in aggiunta alle sue evidenti implicazioni culturali e sociali, materia di notevole interesse, dibattito ed osservazione anche dal punto di vista della governance, e viene – in special modo nel mondo anglosassone[1] – anche considerato come uno degli indicatori strategici di una sana amministrazione del territorio e della collettività; anzi, il ruolo che ricopre l’istruzione nella promozione dell’uguaglianza e della giustizia sociale dovrebbe essere identificato come una delle principali preoccupazioni di quei politici ed alti funzionari che svolgono un incarico centrale nel decidere cosa viene insegnato nelle scuole, dove viene insegnato, a chi e da chi e quanto questo costituisca idonea prerogativa di ingresso nel mondo del lavoro. In linea di principio in tutti i Paesi più sviluppati, lo spostamento dell’occupazione da mansioni manuali e ripetitive a mansioni cognitive non di routine ha almeno tre conseguenze sul mercato del lavoro. In primo luogo, modifica la struttura dell’occupazione: una quota crescente della forza lavoro è impiegata in lavori che richiedono competenze di livello superiore e/o addirittura trasversali. In secondo luogo, cambia la struttura dei salari, giacché la disuguaglianza salariale aumenta a causa dell’incremento del premio per le competenze, in particolare, si allarga il divario salariale tra i lavoratori poco e altamente qualificati. In terzo luogo, la disoccupazione aumenta tra i lavoratori meno qualificati in seguito all’eliminazione dei lavori di routine. In Italia con il Piano da un miliardo e mezzo di euro recentemente varato come previsto nel Piano Nazionale di Ripresa e Resilienza per l’Istruzione per combattere la dispersione scolastica, le povertà educative ed affrontare le disparità territoriali, il Governo dopo i primi interventi in tema di edilizia scolastica, si dedica finalmente agli istituti scolastici con fondi indirizzati direttamente a 3.198 scuole (oltre 400mila studenti) sulla base di precisi indicatori relativi alla dispersione ed al contesto socio-economico per incrementare i risultati di apprendimento degli studenti ed adeguatezza delle loro competenze alla domanda di lavoro.

Si tratta in verità di un ambito estremamente delicato, sovente soggetto ad aspre critiche ed a non del tutto sommesse recriminazioni, all’interno del quale purtroppo le amministrazioni centrali e periferiche italiane, e non solo[2], non sempre realizzano in maniera coerente i principi di una appropriata governance multilivello. A tali questioni si aggiungono ovviamente molteplici, e sovente discordanti, variabili socio-economiche ulteriormente appesantite da un tessuto sociale geograficamente diversificato. Si palesano in effetti una pluralità di micro-ambienti aventi caratteristiche estremamente peculiari e differenziate che rendono ancor più difficoltosa un’azione amministrativa complessiva, ed al tempo stesso incisiva, nelle tre materie d’importanza capitale quali:

- il miglioramento della qualità dell’offerta formativa;

- il rafforzamento delle competenze di base degli allievi;

- la lotta alla dispersione e prematuro abbandono scolastico.

Se poi a queste si considera, peraltro anche a mo’ di cartina tornasole, il tema del match-making tra i profili professionali prodotti dal sistema scolastico nel suo articolato complesso e quelli invece richiesti, sembra a gran voce, dal mercato del lavoro, appare ancor più evidente quanto il tema sia non semplicemente relegato alla mera sfera educativa e culturale, e trasbordi – e per nulla indirettamente – in ambiti sociali ed economici.

Di conseguenza, l’analisi delle principali caratteristiche ed assetti attuali e potenziali prospettive deve spostarsi e concentrarsi prevalentemente sul contenuto intrinseco dello sviluppo educativo: questioni politiche, strategie, misure, risultati, ecc. Ed il concetto stesso di pianificazione educativa[3] diviene fondamentale per consentire la crescita e far funzionare il settore dell’istruzione in modo più efficace, ed implicitamente suggerisce un campo ben strutturato di questioni inequivocabili, obiettivi distintamente definiti, scelte reciprocamente esclusive, indiscusse relazioni causali, razionalità prevedibili e decisori informati e consapevoli. Sfortunatamente, tale inappuntabile approccio sistemico contrasta in maniera stridente con la dura realtà dei sistemi scolastici, laddove la pianificazione educativa consiste invece sovente una serie di episodi disordinati e sovrapposti in cui sono attivamente coinvolte diverse persone e organizzazioni con prospettive diversificate, tanto tecnicamente che politicamente. Comprendere dunque gli scenari attraverso i quali si analizzano i problemi e si generano, si attuano, si valutano e si riprogettano le politiche educative è a dir poco ardua impresa, e le difficoltà appena enunciate si accentuano quando si pone il problema della rilevazione, aggregazione, elaborazione di dati utili alle misurazioni connesse all’efficacia delle politiche stesse.

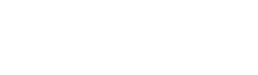

Molteplici sono le indagini, rilevazioni e survey che annualmente vengono realizzate ed aggiornate in tutti i Paesi da istituzioni più o meno autorevoli, ed ancor più numerosi sono i tentativi accademici e politici di individuare gli indicatori (unici o in batteria) che misurino le performance del complesso sistema educativo. Tra questi, ogni tre anni desta notevole, ed universale, interesse – anche da parte della stampa non specializzata e dei non addetti ai lavori – la famosa indagine OCSE-PISA.

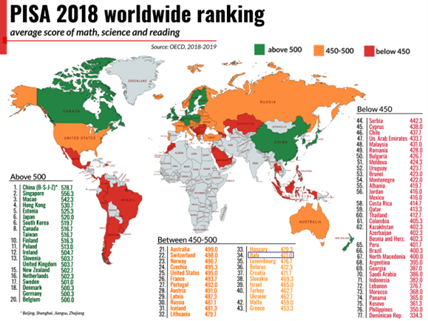

Com’è noto i test PISA (Programme for International Students Assessment) vengono con cadenza triennale somministrati a campione in oltre 80 Paesi del mondo per valutare i livelli di apprendimento dei giovani al temine della scuola dell’obbligo in cinque diversi ambiti (lettura ed interpretazione del testo, matematica, scienze, conoscenze finanziarie, risoluzione di problemi pratici). Più precisamente i tre tradizionali e principali ambiti di competenza che costituiscono il core oggetto delle valutazioni possono essere definiti come segue:

- Literacy (Lettura ed interpretazione del testo): è la capacità degli studenti di comprendere, usare, riflettere e impegnarsi con testi scritti al fine di raggiungere i propri obiettivi, sviluppare la propria conoscenza e il proprio potenziale, e partecipare alla società.

- Numeracy (Competenze Matematiche): è la capacità degli studenti di formulare, impiegare e interpretare la matematica in una varietà di contesti. Include il ragionamento matematico e l’utilizzo di concetti, procedure, fatti e strumenti matematici per descrivere, spiegare e prevedere fenomeni. Consente alle persone di riconoscere il ruolo che la matematica ha nel formulare giudizi e decisioni fondate come cittadini costruttivi, impegnati e riflessivi

- Literacy Scientifica: è l’abilità di confrontarsi con questioni di tipo scientifico e con le idee che riguardano la scienza come cittadino che riflette. Una persona competente dal punto di vista scientifico è disposta a impegnarsi in argomentazioni riguardanti la scienza e la tecnologia che richiedono la capacità di spiegare i fenomeni scientificamente, valutare e progettare una ricerca scientifica, interpretare dati e prove scientificamente.

A questi si sono aggiunti più recentemente[1] test di assessment di:

- Financial literacy e cioè la conoscenza e la comprensione dei concetti e dei rischi finanziari, nonché le competenze, la motivazione e la fiducia per applicare tali conoscenze e comprensioni al fine di prendere decisioni efficaci in una serie di ambiti finanziari, per migliorare il benessere finanziario degli individui e della società e per consentire la partecipazione alla vita economica.

- Collaborative problem solving vale a dire la capacità di utilizzare processi cognitivi per affrontare e risolvere situazioni reali e interdisciplinari in cui il percorso di soluzione non è immediatamente ovvio e in cui le aree di contenuto o quelle curricolari che potrebbero essere applicabili non rientrano in un unico ambito disciplinare di matematica, scienze o lettura.

- Pensiero Creativo inteso come la capacità di impegnarsi in modo produttivo nella generazione, valutazione e miglioramento delle idee, arrivando a soluzioni originali ed efficaci, a progressi nella conoscenza e ad espressioni di immaginazione di grande impatto.

Ed infine, secondo la nuova Vision OCSE PISA 2025, il Strategic Visioning Expert Group ritiene che le conoscenze scientifiche di cui i giovani avranno bisogno dovrebbero essere riorganizzate e aggiornate per prepararli al meglio al mondo in cui vivranno e perciò raccomanda la creazione di tre nuove aree di conoscenza:

– Sistemi socio-ambientali e sostenibilità, per aiutare i giovani a risolvere problemi complessi e interconnessi relativi a questioni che avranno un impatto su di loro.

– Lo sviluppo della conoscenza scientifica e il suo uso improprio, per dare agli studenti una migliore valutazione di come si sviluppa la conoscenza e aiutarli ad orientarsi nello sviluppo di un senso critico nel riconoscere ed evitare l’uso scorretto della conoscenza.

– Informatica, per sottolineare l’importanza dello studio dei dati e della struttura e del comportamento dei sistemi di elaborazione delle informazioni, sia per il loro impatto sulla società attraverso la tecnologia digitale, in particolare l’Intelligenza Artificiale (IA), sia per il loro ruolo nel favorire l’avanzamento della conoscenza in tutti i settori scientifici attraverso modelli computazionali.

L’idea di fondo[1] del sistema di rilevazione OCSE-PISA consiste nel convincimento che combinando le informazioni ottenute dai questionari e dalle prove cognitive, PISA permetta di avere tre tipi di risultati a livello locale, di area e macro-area geografica ed internazionale:

- indicatori di base che forniscano un profilo delle conoscenze e delle abilità degli studenti;

- indicatori derivati dai questionari che mostrino come tali abilità siano associate alle diverse variabili demografiche, sociali, economiche ed educative;

- indicatori di trend che evidenzino i cambiamenti nei risultati, nelle distribuzioni e nelle relazioni tra le variabili a livello studente, a livello scuola e a livello di sistema.

A dire il vero sulla effettiva efficacia informativa dei test PISA il mondo accademico[2] ed anche quello del education[3] formulano e difendono molteplici e discordanti opinioni e non soltanto limitatamente alla metodologia adottata ed ai dati ottenuti. Si lamenta infatti anche come nel corso del tempo, di triennio in triennio il baricentro dell’indagine si sia spostato sempre più verso la misurazione per sé e non sull’effettivo miglioramento della conoscenza e dell’insegnamento[4].

Il problema, infatti, non sembra risiedere soltanto nel framework del test, giacché è innegabile il vantaggio di avere dati imparziali che mostrino a livello comparativo internazionale cosa, e come, i sistemi di istruzione stanno fornendo in termini di nozioni di base, bensì nel modo in cui PISA sia diventato un metro di misura dominante del successo delle scelte politiche operate. Va infatti sottolineato quanto OCSE-PISA sia ormai divenuto un punto di riferimento globale nella valutazione delle performance di education policy[5], e parallelamente al suo consolidamento in termini di autorevolezza si è assistito un po’ dovunque, specie nei Paesi del Sud-Est asiatico, ad una concentrazione degli sforzi sulla scalata alla sua classifica. In altri Paesi, PISA sembra invece aver incrinato l’idea autocelebrata di eccellenza del sistema educativo nazionale. I risultati dei test pubblicati con infografiche sempre più patinate, ma sovente estremamente sintetiche, hanno creato imbarazzi in non pochi contesti politici soprattutto in momenti cruciali ed elettorali insinuando l’associabilità di una posizione puranche media OCSE nel ranking PISA ad una valutazione politica sfavorevole delle scelte di condotta del Governo nel settore scolastico[6].

Al di là della forse non del tutto vacua tensione al primato, e della certamente censurabile caccia ai sensazionalismi, anche in quanto al metodo ed all’interpretazione dei risultati[7] i pareri sono discordanti. Giova ribadire che i dati raccolti dal PISA sono essenzialmente costituiti da tre serie di indipendenti: dati della scuola, dati degli studenti e dati degli insegnanti. I dati delle scuole e degli studenti hanno una propria serie di pesi. I dati degli insegnanti non includono variabili di peso. Nell’utilizzo di questi set di dati, è dunque necessario fare alcune importanti e profonde considerazioni per garantire la corretta creazione e analisi delle informazioni.

A ben vedere la conoscenza – ed ancor più l’abilità – sono entrambe una variabile nascosta alla quale non può direttamente applicarsi alcuna unità di misura naturale. Il test, come tutti i test del resto, comprende un certo numero di domande volte a rivelare il livello di conoscenza dell’esaminando. Tuttavia, poiché in definitiva il punteggio ottenuto nel test dipende in gran misura dalle modalità di distribuzione del livello di difficoltà tra le domande, ne consegue che naturalmente più facili sono le domande, più alto sarà il punteggio. Tutto ciò che ci si può aspettare poi dai metodi statistici è di classificare gli esaminati in base al livello di conoscenza in tal maniera – per così dire convenzionalmente – accertato. Nonostante questa evidente limitazione, economisti ed analisti di dati tendono ad elaborare e calcolare il successo medio degli esaminati secondo diversi raggruppamenti e cluster. Taluni hanno addirittura trovato una corrispondenza quasi uno a uno tra i punteggi PISA e la crescita economica a lungo termine di una nazione, in virtù della quale se si applicassero i medesimi livelli di eccellenza PISA finlandesi a quelli USA[8] questo Paese dovrebbe veder il proprio PIL crescere al ritmo di almeno un trilione di dollari all’anno…; altri applicano modelli di regressioni e correlazioni tra il successo negli studi e il successo in altri campi (vale la pena sottolineare che anche il successo è peraltro una variabile nascosta) i cui risultati in termini di precisione ed implicazioni predittive sembrano a dir poco opinabili.

Malgrado gli aggiornamenti ed affinamenti cui è continuamente sottoposto, PISA conserva una serie di limiti metodologici che riguardano anche i meccanismi di campionamento delle scuole e delle classi che partecipano a nome di ciascun Paese[9] (universo statistico di difficile rappresentazione), tecniche di valutazione e strumenti di misurazione difficili da applicarsi in maniera rigorosa, finanche, secondo alcuni, l’uso opportunistico di punteggi trasformati per finalità di standardizzazione[10]. Al di là della fondatezza del metodo, e delle assunzioni ad esso sottostanti, e della misura di tali elementi di criticità, ciò che sembra preoccupare di più è la sudditanza, e quindi l’affidamento quasi reverenziale, alla significatività statistica delle risultanze, in assenza invece di osservazioni che si concentrino sull’entità degli effetti e del loro impatto sui sistemi. Ciò nonostante si tratta comunque di uno strumento di notevole portata sia in termini di dettaglio che di universalità della rilevazione[11] che, se opportunamente e ragionevolmente considerato – pur sempre con le sue limitazioni – può fornire informazioni, visioni e misurazioni per stimare lo stato dell’arte del education e disegnare realizzare education policy consone agli obiettivi politici e strategici, soprattutto considerato che a causa dell’impatto che i successi e gli abbandoni scolastici hanno su intere comunità e sulla nazione, il diploma di scuola superiore è valutato in alcuni Paesi industrializzati come il miglior pacchetto di stimolo economico.[12]

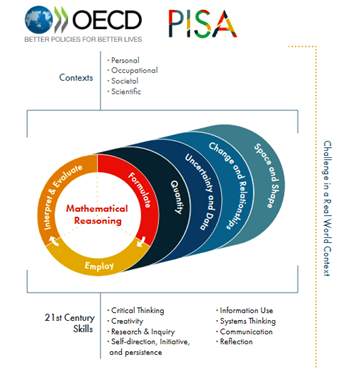

Risulta infatti interessante notare che la popolazione OCSE oggetto della valutazione PISA è costituita da studenti iscritti in qualunque istituzione educativa (più precisamente con quindicenni OCSE PISA si intendono studenti che al momento della somministrazione del test abbiano un’età compresa tra 15 anni e 3 mesi e 16 anni e 2 mesi), e che abbiano completato almeno 6 anni di istruzione formale. E che è proprio in tale fascia d’età che si concentrano i casi – e quindi la maggiore probabilità – di abbandono scolastico[13] ed altresì ben evidente che in quanto a performance in termini di conoscenze trasversali degli allievi, si riscontra una evidente correlazione tra illiteracy ed abbandono scolastico (tendenza a dire il vero niente affatto nuova[14]) oppure con l’emarginazione socio-economica[15]. Gli studenti che lasciano prematuramente gli studi vi sono costretti delle carenze di quelle competenze necessarie se non per avere successo nella scuola superiore, almeno per tenere il passo degli altri – e la situazione si aggrava e spesso si consolida nel dropout dettato da necessità economiche familiari[16].

Senza solide competenze[17], e con background critici[18] gli studenti hanno dunque meno opportunità di avere successo, di intraprendere un percorso accademico e più probabilità di abbandonare la scuola superiore prima del diploma. A tale fenomeno si associa sovente la conseguente disparità anche dei livelli qualitativi degli insegnanti e dell’insegnamento in generale[19], poiché a causa della scarsa appetibilità professionale di alcune sedi ed istituti proprio a questi finiscono col relegarsi non le migliori risorse umane di cui il sistema educativo dispone[20]. È indubitabile invece che l’istruzione formale abbia un effetto causale sostanziale sulle competenze cognitive e che la scuola dell’obbligo sia la determinante principale delle competenze di base in materia di alfabetizzazione, calcolo e risoluzione di problemi ed il rendimento dell’istruzione rappresenta l’effetto combinato dell’istruzione sulla produzione di competenze alfabetiche e numeriche e il valore attribuito a tali competenze nel mercato del lavoro, anzi la scolarizzazione influisce con effetto diretto e misurabile delle competenze cognitive di lettura e calcolo cui viene associato a un aumento dei guadagni proporzionale agli anni di scuola frequentati[21].

Questo articolato e complesso genere di informazioni e riflessioni, naturalmente prima facie giudicabili forse banali, se invece ben circostanziate, dettagliatamente geolocalizzate e misurate da serie storiche di dati rigorosamente collezionati e da correlazioni ed estrapolazioni fondate su assunzioni ragionevolmente accogliibili possono di certo dir molto ed assistere processi decisionali e di policy making nazionali e regionali[22] al fine di invertire il segno dei tre gap scolastici più profondi e diffusi evidenziati dal PISA: quello di gender, quelli socio-economici e quelli che penalizzano le scuole vocational.

Va però segnalato, proprio sul piano della governance complessiva del sistema educativo-occupazionale, che nonostante i tassi medi di iscrizione e di chiusura del ciclo di studi generalmente medio-alti, nonché un’istruzione di qualità tutto sommato rispettabile secondo il ranking PISA per il livello di reddito pro-capita, il job-skill mismatch in molti Paesi sviluppati sembra rimanere un problema a causa della carenza di adeguate competenze sul mercato del lavoro[1]. Si tratta di una contraddizione che non può essere risolta facilmente, soprattutto perché mancano informazioni cruciali, giacché, non esistono molti dati ed informazioni comparabili a livello internazionale sulla qualità dell’istruzione secondaria superiore o terziaria in ragione della sua aderenza e pertinenza ai sistemi di sviluppo socio-economico ed ai meccanismi di reclutamento, in modo da avere serie storiche e dataset che indichino se i diplomati/laureati abbiano le competenze adeguate alla domanda del mercato del lavoro moderno. A tal proposito giova ricordare che gli stessi OCSE PISA forniscono informazioni sulle competenze degli studenti di 15/16 anni, un’età in cui tuttavia pochi tentano seriamente il proprio ingresso sul mercato del lavoro. Peraltro, al di là del age range le informazioni disponibili sulle competenze degli studenti si riferiscono solo alle loro abilità cognitive fondamentali, e non già a quelle comportamentali che riguardano aspetti come l’etica del lavoro, il rispetto dei vincoli gerarchici, la creatività finalizzata e il lavoro di squadra, che sono invece particolarmente apprezzate dai datori di lavoro. Pertanto se è vero che il sistema educativo ha tra i suoi scopi quello di predisporre e favorire le condizioni oggettive e soggettive per un più probabile inserimento nel mondo del lavoro, a sistemi di rilevazione come OCSE PISA, legati alla (peraltro criticata) misurazione dei livelli di conoscenza ed abilità non può ragionevolmente chiedersi anche l’apprezzamento del grado di occupabilità dello studente. E pertanto affinché policy maker possano comprendere meglio le cause dell’emergente carenza di competenze – e come affrontarla sia in sede di pianificazione professionale che di reclutamento – è necessario colmare questa lacuna informativa mediante appositi analisi e studi approfonditi che però rispondano ad altre domande di ricerca.

Nelle more del dibattito questa primavera oltre 600.000 studenti selezionati in 88 Paesi come campione di rilevazione periodica PISA hanno partecipato ai test (giacché la pandemia non ha risparmiato l’indagine triennale OCSE che dal canonico 2021 è stata postergata al 2022). ed i loro risultati raccolti ed elaborati confluiranno a fine anno nei Report OCSE-PISA che verosimilmente vedranno come al solito primeggiare i Paesi del sud-est asiatico e della Scandinavia, indigneranno alcuni Paesi occidentali per lesa maestà educativa, premieranno gli sforzi di qualche Paese in via di sviluppo, forniranno motivo di vanto a qualche fortunato politico campione iridato grazie a chissà quale opinabile regressione statistica, e che come consueto situeranno l’Italia nei dintorni della media mondiale, ed in particolare designeranno le regioni del nostro Mezzogiorno e gli studenti degli istituti tecnici e professionali colpevoli di aver abbassato anche stavolta il ranking nazionale, dando luogo ai soliti stucchevoli sensazionalismi giornalistici e ad un diffuso ed altrettanto sterile sdegno.

[1] Ljiljan Veselinović, Jasmina Mangafić, Lejla Turulja , The effect of education-job mismatch on net income: evidence from a developing country, Economic Research, VOL. 33, NO. 1, 2648–2669, 2020.

[1] v, OECD – PISA 2024 Strategic Vision and Direction for Science. 2022

[2] cfr. Shlomo Yitzhaki “On the Reliability of the Findings of PISA Tests” Journal of Social Sciences, Feb. 2016.

[3] Cfr. Yong Zhao: The PISA Illusion, National Education Policy Center, University of Colorado at Boulder, December 12, 2019

[4] v. Jo Owen, The race for Pisa test points is obscuring the key to successful education, Financial Times Special Report Innovation in Education, 2017.

[5] Cfr, Valerie Strauss, How PISA created an illusion of education quality and marketed it to the world, The Washington Post, December 3, 2019

[6] Cfr. Nathalie Mons, Xavier Pons, Pourquoi n’y a-t-il pas eu de « choc PISA » en France ? Sociologie de la réception d’une enquête international, Revue française de pédagogie, 182, 2013

[7] v. David Kastberg, Loydis Cummings, David Ferraro, Robert Perkins – Technical Report and User Guide Program for International Student Assessment (PISA), Institute of Education Sciences, 2021.

[8] v. Amanda Ripley, The Smartest Kids in the World, New York, Simon & Schuster, 2013

[9] v. Gary Sands, Are The PISA Education Results Rigged? Forbes, Jan 4, 2017

[10] Cfr. Antonio Fernandez-Cano, Una crítica metodológica de las evaluaciones PISA, Revista ELectrónica de Investigación y EValuación Educativa, 11 Mayo, 2016

[11] V. Therese N. Hopfenbeck, Jenny Lenkeit, Yasmine El Masri, Kate Cantrell, Jeanne Ryan & Jo-Anne Baird, Lessons Learned from PISA: A Systematic Review of Peer-Reviewed Articles on the Programme for International Student Assessment, Scandinavian Journal of Educational Research, 62:3, 333-353, 2018.

[12] Carolyn L. Carlson. Adolescent Literacy, Dropout Factories, and the Economy: The Relationship between Literacy, Graduation Rates, and Economic Development in the United States. Washburn University Department of Education, Journal of Education and Human Development, June 2013.

[13] v. CEDEFOP, Leaving education early: putting vocational education and training centre stage Volume II: evaluating policy impact, 2016

[14] Cfr. R.A. Dentler, M.E. Warshauer, Big city dropouts and illiterates. 1965, Center for Urban Education, New York, NY. ed anche Michael Bernick, Illiteracy and Inner-City Unemployment The Phi Delta Kappan 1986, Vol. 67, No. 5,

[15] Cfr. Ammermueller Andreas.. Poor background or low returns? Why immigrant students in Germany perform so poorly in PISA. Education Economics, 15(2), 2007.

[16] v. Arikan, S., van de Vijver, F. J., & Yagmur, K. PISA mathematics and reading performance differences of mainstream European and Turkish immigrant students. Educational Assessment, Evaluation and Accountability, 229–246, 2017

[17] Cfr. Aikens, N. L., , Barbarin, O. .Socioeconomic differences in reading trajectories: The contribution of family, neighborhood, and school contexts. Journal of Educational Psychology, 100(2), 235–251, 2008.

[18] v. Celeste, L., Baysu, G., Phalet, K., Meeussen, L., & Kende, J. (2019). Can school diversity policies reduce belonging and achievement gaps between minority and majority youth? Multiculturalism, colour-blindness, and assimilationism assessed. Personality and Social Psychology Bulletin, 45(11), 1603–1618

[19] Jose Marquez, Louise Lambert, Natasha Ridge, The PISA performance gap between national and expatriate students in the United Arab Emirates, Journal of Research in International Education, April 20, 2022

[20] Helen Abadzi, Stavri Llambiri , Selective teacher attention in lower-income countries: A phenomenon linked to dropout and illiteracy Prospects, 41, . 2011

[21] David A. Green W. Craig Riddell. Understanding Educational Impacts: The Role of Literacy and Numeracy Skills, Department of Economics University of British Columbia May 2012

[22] V. Must try harder. What the world can learn from the latest PISA test results, The Economist, December, 2016

[1] Cfr, OECD – PISA Assessment and Analytical Framework, 2018

[1] Cfr. Emma Smith, Key Issues in Education and Social Justice. University of Warwick, 2012.

[2] Cfr. Lars Sondergaard, Mamta Murthi; Dina Abu-Ghaida, Christian Bodewig, Jan Rutkowski. Skills, Not Just Diplomas: Managing Education for Results in Eastern Europe and Central Asia. World Bank. 2012.

[3] Cfr. Wadi D. Haddad, Education policy-planning process: an applied framework UNESCO: International Institute for Educational Planning.,1995